Interpretación de los mapas sistémicos y diagramas que aparecen en la RAM de México

El Centro-i para la Sociedad del Futuro elaboró el documento que aplica la Metodología de Evaluación de Capacidades en Inteligencia Artificial de la UNESCO (Readiness Assessment Methodology, RAM, por sus siglas en inglés) para México, mismo que fue dado a conocer públicamente el 3 de julio de 2024 en la Ciudad de México.

En esta sección se amplían las explicaciones relativas a los mapas y diagramas incluidos en el documento. Para facilitar su ubicación en el mismo, se les identifica con la misma numeración que tienen en el documento.

Figura 15: Ecosistema del desarrollo ético de la inteligencia artificial

Este es un mapa ecosistémico que representa, en una escala genérica y sin considerar la cronología de los efectos, una estructura básica del ecosistema del desarrollo ético de la inteligencia artificial (IA).

El primer paso para interpretar correctamente el mapa es conocer los elementos que lo constituyen, que son dos:

- Las variables que forman la estructura del sistema, las cuales están representadas por los textos que aparecen en el mapa. Nótese que la definición de las variables siempre se refiere a una cantidad o un aspecto que puede cambiar de estado o de valor, ya sea en términos cuantitativos o cualitativos.

- Las flechas que conectan a las variables del sistema, las cuales siempre indican un sentido de causalidad que va de la variable origen a la variable destino. Los signos algebraicos indican el tipo de relación causal existente entre las variables. Un signo (+) indica que los aspectos o cantidades representadas por las variables se mueven en el mismo sentido, es decir, que si la variable origen incrementa su valor, entonces la variable destino también incrementa su valor. Siguiendo la misma lógica, si la variable origen disminuye su valor, entonces la variable destino también disminuye el suyo.

Un signo (-) indica que los aspectos o cantidades representadas por las variables se mueven en sentido contrario, es decir, que si la variable origen incrementa su valor, entonces la variable destino disminuye su valor. Siguiendo la misma lógica, si la variable origen disminuye su valor, entonces la variable destino incrementa el suyo.

Tomando en cuenta lo anterior, enseguida procedemos a explicar cómo interpretar el mapa que representa un ecosistema muy general del desarrollo ético de la inteligencia artificial (IA). Vemos en primer lugar que la coordinación entre los actores relevantes del ecosistema digital sobre las posibles iniciativas de diseño institucional del ente o sistema regulador de la IA, incide directamente sobre otras dos variables: la intensidad y congruencia de cambios en marcos legales para avanzar en la inclusión de principios éticos de IA, y en la oportunidad y eficacia del nuevo entorno de gobernanza de la IA.

La primera variable se refiere a las posibilidades de coordinación entre diferentes actores para poner en marcha un esquema que regule diferentes actividades del ciclo de vida de la IA. Se puede entender que la coordinación mejora cuando los actores relevantes logran avanzar en el proceso de diseño e implantación del esquema regulatorio; por el contrario, se puede entender que la coordinación empeora cuando los actores relevantes no logran ponerse de acuerdo en un tipo de diseño institucional o se atoran en algunas de las barreras jurídicas, de ingeniería legislativa, políticas o de otro tipo que tienen que salvar para poder avanzar en el proceso.

Las relaciones funcionales que esta última variable sostiene con las otras dos variables mencionadas están indicadas con un signo (+), lo cual significa que si la coordinación entre actores mejora, la intensidad y congruencia de los cambios en los marcos legales crecen o mejoran, y la oportunidad y la eficacia del nuevo entorno de gobernanza de la IA también mejoran.

Decir que la intensidad de los cambios en los marcos legales crece significa que la velocidad con la que se realizan los cambios necesarios aumenta; cuando decimos que la congruencia se incrementa o mejora, nos referimos a que los cambios propuestos están mejor alineados y por lo tanto no se contraponen o se anulan entre ellos.

En cuanto a la oportunidad del nuevo entorno de gobernanza de la IA, nos referimos a qué tan oportuna es la implementación del nuevo esquema acordado por los actores relevantes y propiciado por los cambios legales realizados. Dadas las altas velocidades observadas en el desarrollo de la IA, la implementación del esquema de gobernanza será más oportuna mientras menos tiempo se tome para ponerse en marcha. De la misma manera, decimos que la eficacia del esquema de gobernanza mejora cuando los actores relevantes logran coordinarse mejor y cuando los cambios legales se hacen rápidamente y de manera congruente, porque esta combinación permite entender mejor y más rápido la evolución y los efectos de la IA, y por lo tanto entender mejor los retos de la gobernanza y en consecuencia atenderlos más eficazmente.

Ahora bien, un esquema de gobernanza de IA oportuno y eficaz tiene los siguientes efectos directos:

- Facilita la inclusión de criterios éticos en el desarrollo, evaluación y validación de los sistemas de IA porque las cualidades de oportuno y eficaz provienen en buena medida de una buena coordinación entre actores relevantes, lo cual implica también una buena disposición para el trabajo colaborativo, lo que a su vez facilita la aplicación de criterios éticos que regulen las actividades y las conductas de los desarrolladores y los grandes usuarios de IA.

- Facilita el diseño y la aplicación de incentivos al desarrollo de sistemas éticos de IA como consecuencia del trabajo colaborativo desarrollado en el sistema de gobernanza, pero también por la disposición para incluir criterios éticos en todo el ciclo de los sistemas de IA. El desarrollo comercial de estos sistemas responde a una dinámica propia que avanza a gran velocidad, pero un aspecto de particular importancia en este ecosistema es que los factores que se han venido mencionando también propician el diseño y aplicación de incentivos para el desarrollo ético de sistemas de IA de interés público, los cuales suelen ser desdeñados por el mercado pero que son cruciales para mover el sistema hacia estados con mejores niveles de bienestar general.

Como se observa en el mapa, la inclusión de criterios éticos y la aplicación de incentivos para la inversión en ambos tipos de sistemas de IA también se favorece de la infusión de pensamiento crítico y sistémico, lo cual puede hacerse tanto en el ámbito en el que se discuten y definen dichos criterios, como en los sistemas educativos y de capacitación para propiciar efectos de largo plazo.

La inversión en desarrollos éticos de IA, tanto los comerciales como los de interés público, se favorece de la aplicación de incentivos y de la enseñanza de habilidades blandas, o socioemocionales, que faciliten la integración laboral. Todos estos factores propician la competencia entre desarrolladores, lo cual en este contexto favorece la innovación con criterios éticos.

En esta parte de la interpretación vale la pena incluir algunos argumentos sobre la relación entre innovación y regulación, pues son conceptos que han estado al centro de acendrados debates sobre las mejores maneras de promover el desarrollo del ecosistema digital en lo general, y de la inteligencia artificial en lo particular. Se suele repetir en muchos foros que hay que tener cuidado con la aplicación de mecanismos regulatorios porque éstos frenan la innovación, pero lo que no se suele decir es que la innovación no es el resultado de una única actividad regulable y que lo que sí se puede hacer es aplicar acciones y diseños institucionales para crear un entorno regulatorio que no frene, sino que promueva la innovación ética y responsable.

La innovación es el resultado de una combinación de condiciones y actividades realizadas en varios ámbitos o sectores que se interrelacionan directa o indirectamente, y que pueden retroalimentarse en círculos virtuosos o contrarrestarse en círculos viciosos. Algunas de estas actividades son potencialmente regulables y otras no, lo cual significa que una cierta combinación regulatoria puede inhibir un tipo de innovación y otra combinación puede incrementarla. Esta discusión seguirá siendo fundamental en el caso de la IA.

Un marco como este permite visualizar por qué la gobernanza ética y la regulación responsable no sólo son absolutamente consistentes con la innovación y el crecimiento económico, sino que ambas son esenciales para asegurar un ecosistema de IA que promueva el bien común. Las recomendaciones que se presentan en la RAM de México están enfocadas al desarrollo de un modelo que no se limita a impulsar el crecimiento económico per se, como medida única de desarrollo, sino que está abierto a la consideración de otras medidas de bienestar de la población para que sean reconocidas como objetivos más humanos y duraderos de desarrollo. El propósito es alinearse con una teoría del cambio que no replique lo que se ha observado en muchas ocasiones en diferentes países: períodos de crecimiento económico durante los cuales se incrementan las desigualdades y las brechas socioeconómicas, tecnológicas y de género, que desembocan en crisis no sólo económicas, sino políticas y sociales.

Regresando al mapa, observamos que los incrementos de inversión y de innovación con criterios éticos favorecen el desarrollo de sistemas de IA entrenados con ese tipo de criterios, lo cual es muy positivo porque dichos criterios quedan inmersos en varias cadenas de efectos: promueven incrementos de productividad y reducciones de costos sin usar mecanismos abusivos; contribuyen a la reducción de brechas digitales, económicas y sociales; ayudan a reducir las amenazas a la privacidad, a la competencia, a la propiedad intelectual y a la democracia; y contribuyen a la eventual disminución de la concentración de la riqueza. La escala utilizada para la construcción de este mapa ecosistémico utiliza factores y variables definidas de manera amplia, por lo que no se incluyen cadenas de efectos más puntuales o detalladas. Sin embargo, cuando se trata de diseñar políticas públicas el diseño de estrategias ecosistémicas sí requiere de reducir la escala del mapa para captar los efectos sobre las decisiones y las conductas de las personas y de los equipos de trabajo.

Cuando se trabaja en esas escalas se entra a espacios en los que es necesario considerar la psicología individual y colectiva de los actores, así como los juegos de poder que definen los procesos de negociación y toma de decisiones.

La evolución continua de los ecosistemas sociales va cambiando las preferencias y las conductas de los actores que los constituyen, como las personas, los gobiernos y las organizaciones públicas y privadas de toda índole. Este fenómeno provoca que los objetivos de las políticas públicas también se vayan modificando continuamente. El enfoque tradicional no toma en cuenta este tipo de complicaciones al diseñar las políticas públicas porque implícitamente asume que los gobiernos son entidades que operan fuera de los ecosistemas en los que se observan los problemas que se quiere resolver. Otra forma de decirlo es que en las metodologías convencionales tanto el diseño como la aplicación de las políticas públicas se consideran exógenas a la dinámica de los sistemas económicos y sociales sobre los que se quiere incidir.

El enfoque metodológico de los sistemas complejos es completamente distinto. En ese caso tanto los gobiernos como los mercados se conciben como productos generados por la dinámica de los ecosistemas sociales. La arquitectura de los gobiernos, los diseños institucionales y las reglas que definen el funcionamiento de los mercados son determinados por los valores culturales y las preferencias sociales predominantes en cada nación, lo cual significa en la práctica que los gobiernos y los mercados interactúan continuamente con la sociedad dentro del mismo ecosistema.

Si se parte de un escenario como el que se describe, y contrariamente a lo que sostienen escuelas de pensamiento como la economía neoclásica, las políticas públicas no tienen la capacidad de controlar ni la conducta de la gente ni el desempeño de la economía, pero sí cuentan con muchos instrumentos para incidir sobre dichos comportamientos para llevar paulatinamente al sistema hacia los resultados deseados. Esta es la razón de fondo que permite entender por qué las políticas públicas diseñadas exógenamente bajo enfoques tradicionales, que identificamos genéricamente como de pensamiento lineal, no alcanzan los objetivos que se plantean, no cumplen con los plazos prestablecidos y en muchas ocasiones generan efectos y resultados nulos o contraproducentes.

Formalmente hablando, las diferencias metodológicas basadas en el pensamiento lineal y en el pensamiento sistémico son muy significativas. Por ejemplo, una aproximación lineal asume que las relaciones entre los problemas y sus causas, y entre las soluciones y sus efectos, son lineales (en el sentido matemático del término, por ejemplo, que son directamente proporcionales), obvias, directas y siempre identificables.

Por el contrario, un enfoque sistémico reconoce que las relaciones entre los problemas y sus causas, y entre las soluciones y sus efectos no son obvias, pueden ser indirectas o permanecer ocultas a nuestro entendimiento, se pueden dar diacrónicamente y casi siempre son no lineales en términos espaciales y temporales (son representadas por funciones exponenciales). Aún más, una acción sobre el sistema puede generar que se den efectos simultáneos con diferentes trayectorias, con diferentes frecuencias y a diferentes velocidades.

Cuando rescatamos estos conceptos para aplicarlos al diseño de política públicas, se ve claramente la enorme diferencia entre ambos enfoques. Una de esas diferencias se refiere a que en las metodologías lineales se asume que las acciones acordadas siguen un solo hilo conductor en el tiempo y que los efectos de corto plazo son los mismos que se observan en el largo plazo.

Contrariamente a lo anterior, una metodología basada en sistemas complejos asume que una acción de corto plazo genera efectos o impactos dinámicos, de naturaleza no lineal, que pueden ir cambiando en el tiempo y que muchas veces resultan insospechados o hasta contrarios a los esperados. Además, se reconoce que se puede mejorar el todo sin tener que incidir en cada una de sus partes, lo cual depende, por ejemplo, de la naturaleza de las relaciones entre éstas. Ello significa por ejemplo que incidir sobre un número relativamente pequeño de funciones críticas del sistema, con los recursos y los tiempos adecuados y suficientes, puede generar eficazmente los efectos o impactos esperados.

Regresando a la escala genérica del mapa observamos la formación de un círculo virtuoso, es decir de reforzamiento positivo, cuando el incremento de la demanda de bienes y servicios generada por los sistemas de IA hace que se incremente la inversión en el desarrollo ético de estos sistemas, tanto de los comerciales como de los de interés público.

Figura 17: Elementos a considerar para el diseño de las estrategias sistémicas que propicien el desarrollo ético de la inteligencia artificial

La RAM presenta un panorama suficientemente claro de cuáles son las fortalezas y los desafíos de México en materia de IA, lo que ha sido tomado en cuenta para integrar una lista de recomendaciones para mejorar la situación del país en esta materia.

Cada una de las recomendaciones encaja en algunos de los puntos del entramado que da estructura y funcionalidad al ecosistema de la IA. El mapa que aparece a continuación sirve para resaltar que las recomendaciones no pueden ser tomadas independientemente sino como partes del mismo ecosistema.

A diferencia del mapa anterior, en el que se representan algunas relaciones funcionales, este es una representación esquemática para insistir en que las recomendaciones no pueden concebirse aisladas, o como acciones independientes, porque muchas de ellas están funcionalmente relacionadas.

Los conceptos que aparecen en los globos son parte de las recomendaciones y constituyen temas o aspectos críticos de la hoja de ruta.

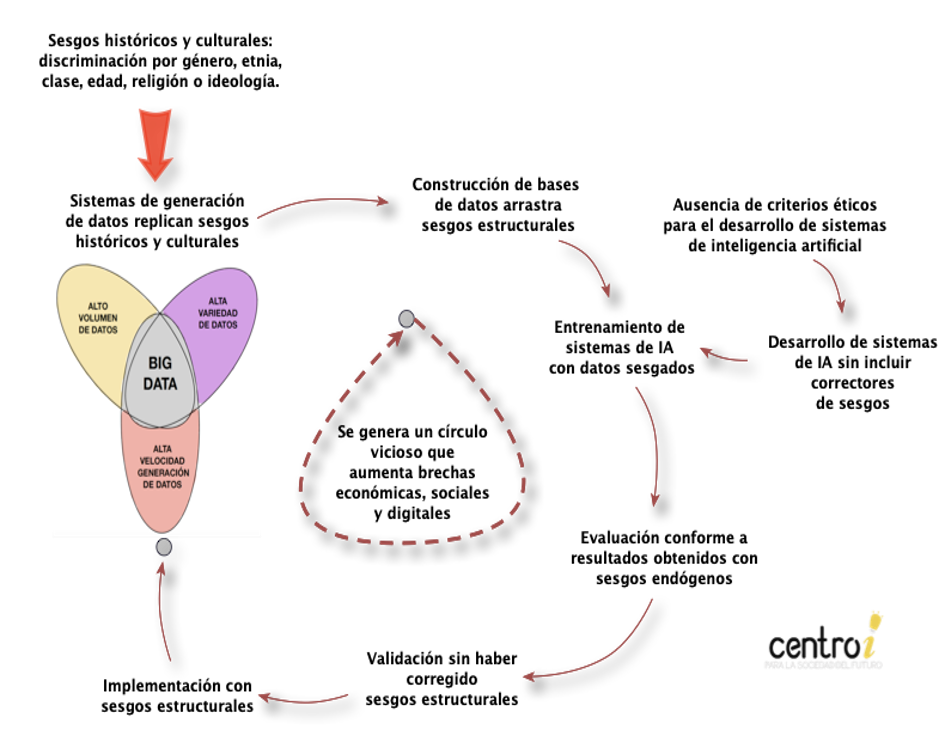

Figura 18: Ciclo de arrastre de sesgos estructurales en el desarrollo de sistemas de inteligencia artificial

El arrastre de sesgos estructurales en el ciclo de vida de la IA se refiere a la perpetuación y amplificación, a lo largo de las diferentes etapas del desarrollo y despliegue de los modelos, de sesgos existentes en los datos y sistemas de IA. Generalmente estos sesgos provienen de varias fuentes, suelen tener orígenes históricos y culturales, y los efectos negativos y los daños que causan provocan círculos viciosos que agravan los problemas de discriminación y las desigualdades.

El diagrama muestra las principales etapas del ciclo de arrastre de los sesgos estructurales; en los párrafos siguientes se hacen comentarios específicos sobre cada una de las etapas.

- Definición del caso y recolección de datos

Al definir los objetivos del caso que se quiere abordar y decidir qué datos recolectar, pueden introducirse sesgos de selección si ciertos grupos o características no están bien representados en los datos. Esto sucede frecuentemente debido a que muchos de los datos existentes han sido generados en ecosistemas históricamente discriminatorios en aspectos de género, etnia, clase, edad, religión o ideologías. El ejemplo más claro es el de género, pues las mujeres representan el 50% de la población mundial y sin embargo están mayoritariamente subrepresentadas en la mayoría de las bases de datos. Por mencionar sólo algunos ejemplos típicos: en las de investigación médica y diseño de técnicas y procedimientos de curación, en las de desarrollo de medicamentos, en las de empleo, en las financieras y de otorgamiento de créditos, en las de diseño de automóviles, en las de uniformes y equipo especializado, en las de planeación urbana y hasta en el diseño de baños públicos[1].

- Construcción y preprocesamiento de datos

La construcción de las bases de datos incluye los procedimientos que los dejan listos para poder utilizarlos en el entrenamiento de los modelos. La ausencia de filtros adecuados y los procesos convencionales de normalización y escalado de datos favorecen inadvertidamente la permanencia o replicación de sesgos.

- Entrenamiento del modelo

La ausencia de principios y técnicas de corrección de sesgos provoca discriminación algorítmica, esto es, los modelos son entrenados con datos sesgados de origen, el algoritmo no lo corrige y en consecuencia produce resultados que replican o amplifican los sesgos.

- Evaluación del modelo

Si el diseño de las métricas de evaluación no se realiza tomando en cuenta los sesgos de las bases de datos, los sesgos pasan inadvertidos. Lo mismo sucede cuando la muestra de datos utilizada no es suficientemente representativa de todos los grupos a considerar.

- Validación y despliegue del modelo

Si el modelo se valida y se despliega sin haber corregido el arrastre de sesgos, éstos se perpetúan y se amplifican. La discriminación algorítmica se enriquece con los datos existentes (el big data en el diagrama), los cuales ya traen los sesgos históricos, el círculo vicioso se mantiene y agarra una inercia que se va incrementando iterativamente.

[1] Para leer más sobre los sesgos históricos y estructurales del diseño y planeación de las ciudades visitar: https://centroi.org/la-ciudad-feminista/

Figura 19: Oportunidades de corrección de sesgos en el ciclo de vida de los datos

Este diagrama muestra algunos de los puntos en los que se puede incidir para corregir el arrastre de los sesgos en el ciclo de vida de los datos. De entrada es imprescindible abrir una reflexión sobre las causas y los alcances de los sesgos históricos y culturales en los ecosistemas sociales de los que formamos parte, así como incluir en la discusión el uso de criterios éticos para entender de qué manera los valores tradicionales han generado y mantenido dichos sesgos.

La corrección del arrastre de sesgos requiere de la formación de equipos de trabajo incluyentes y multidiversos para tratar de incorporar todos los enfoques y perspectivas posibles. Para romper con la inercia de los equipos tradicionales y monotemáticos es necesario tomar conciencia de los alcances que este punto tiene sobre el funcionamiento del ecosistema digital y en particular sobre el desarrollo de la IA. Los sesgos estructurales surgen a la vista cuando en los equipos de trabajo hay personas que han vivido y experimentado algún tipo de discriminación o han padecido los efectos de alguna desigualdad.